Presentan un recurso judicial preventivo contra las “deepfakes” en la campaña electoral

El abogado constitucionalista Andrés Gil Domínguez presentó un una acción de amparo electoral preventiva colectiva ante la justicia, buscando que el Estado Nacional adopte antes de las próximas elecciones nacionales de octubre medidas efectivas para prevenir, alertar y hacer cesar las “deepfakes” o noticias falsas basadas en videos apócrifos donde se clona la voz y el rostro con Inteligencia Artificial (IA).

La demanda busca evitar que los electores sean inducidos a engaño a la hora de votar y apunta contra la Jefatura de Gabinete de Ministros y la Subsecretaría de Asuntos Políticos. La causa recayó en el juzgado federal electoral de María Servini.

El objeto de la acción es proteger el derecho a elegir libremente en un proceso electoral transparente.

El abogado dijo que las “deepfakes” son contenidos generados por IA (audio, imágenes, videos) diseñados para imitar de manera realista la apariencia y el comportamiento de una persona, a menudo con la intención de engañar a los espectadores.

La demanda subraya que la IA generativa produce datos sintéticos que pueden distorsionar la información existente o crear contenido que nunca existió, repercutiendo en la noción de realidad y ficción.

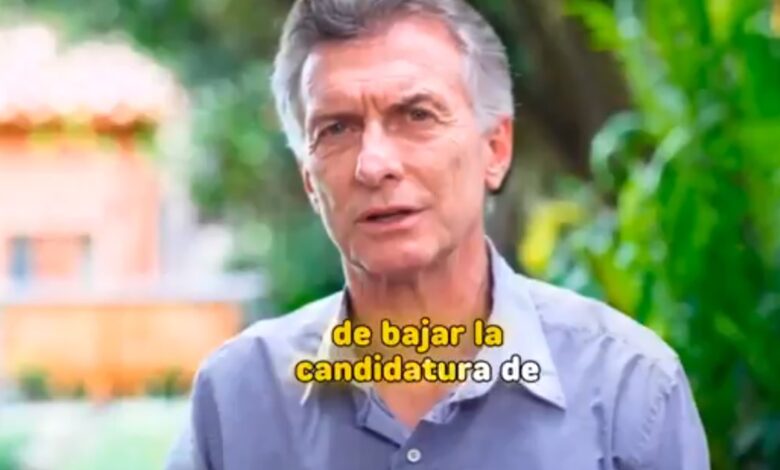

Y citó como antecedentes lo ocurrido en la veda electoral del 18 de mayo de 2025, en la campaña para legisladores porteño, cuando se difundieron videos generados con IA simulando al expresidente Mauricio Macri y a la diputada Silvia Lospennato, quienes desmintieron rápidamente los contenidos en los que se recomendaba votar por el candidato de Javier Milei, Manuel Adorni.

El Tribunal Electoral de CABA ordenó la eliminación de los videos en la red social “X”. “Este episodio evidenció los desafíos para la integridad electoral”, dijo el abogado, ya que se violó la veda y “pudo haber impactado en el resultado, dado que el candidato promovido en el video falso, Manuel Adorni, resultó ganador”.

En Córdoba, semanas atrás, un video con voz e imagen del gobernador Martín Llaryora, generado con IA, fue viralizado por un diputado nacional, pronunciando un discurso que no era real.

“Estos incidentes no son aislados. El informe AI Index 2024 de la Universidad de Stanford advirtió que los deepfakes políticos ya están afectando los procesos electorales en todo el mundo”, dijo Gil Domínguez.

Y citó como ejemplo las elecciones en Estados Unidos de 2024 (Donald Trump y Kamala Harris), las elecciones de Brasil en 2022 (Lula da Silva y Jair Bolsonaro), y un deepfake del presidente de Ucrania, Volodímir Zelenski, pidiendo la rendición de sus tropas en 2022.

La Cámara Nacional Electoral, en el caso “Villaver, María Victoria”, ya determinó que estas conductas pueden subsumirse en el artículo 140 del Código Penal (inducir al error al sufragante) y reafirmó que el objetivo es “mantener la pureza del sufragio como base de la forma representativa de gobierno”.

El abogado constitucionalista Andrés Gil Domínguez presentó un una acción de amparo electoral preventiva colectiva ante la justicia, buscando que el Estado Nacional adopte antes de las próximas elecciones nacionales de octubre medidas efectivas para prevenir, alertar y hacer cesar las “deepfakes” o noticias falsas basadas en videos apócrifos donde se clona la voz y el rostro con Inteligencia Artificial (IA).

La demanda busca evitar que los electores sean inducidos a engaño a la hora de votar y apunta contra la Jefatura de Gabinete de Ministros y la Subsecretaría de Asuntos Políticos. La causa recayó en el juzgado federal electoral de María Servini.

El objeto de la acción es proteger el derecho a elegir libremente en un proceso electoral transparente.

El abogado dijo que las “deepfakes” son contenidos generados por IA (audio, imágenes, videos) diseñados para imitar de manera realista la apariencia y el comportamiento de una persona, a menudo con la intención de engañar a los espectadores.

La demanda subraya que la IA generativa produce datos sintéticos que pueden distorsionar la información existente o crear contenido que nunca existió, repercutiendo en la noción de realidad y ficción.

Y citó como antecedentes lo ocurrido en la veda electoral del 18 de mayo de 2025, en la campaña para legisladores porteño, cuando se difundieron videos generados con IA simulando al expresidente Mauricio Macri y a la diputada Silvia Lospennato, quienes desmintieron rápidamente los contenidos en los que se recomendaba votar por el candidato de Javier Milei, Manuel Adorni.

El Tribunal Electoral de CABA ordenó la eliminación de los videos en la red social “X”. “Este episodio evidenció los desafíos para la integridad electoral”, dijo el abogado, ya que se violó la veda y “pudo haber impactado en el resultado, dado que el candidato promovido en el video falso, Manuel Adorni, resultó ganador”.

En Córdoba, semanas atrás, un video con voz e imagen del gobernador Martín Llaryora, generado con IA, fue viralizado por un diputado nacional, pronunciando un discurso que no era real.

“Estos incidentes no son aislados. El informe AI Index 2024 de la Universidad de Stanford advirtió que los deepfakes políticos ya están afectando los procesos electorales en todo el mundo”, dijo Gil Domínguez.

Y citó como ejemplo las elecciones en Estados Unidos de 2024 (Donald Trump y Kamala Harris), las elecciones de Brasil en 2022 (Lula da Silva y Jair Bolsonaro), y un deepfake del presidente de Ucrania, Volodímir Zelenski, pidiendo la rendición de sus tropas en 2022.

La Cámara Nacional Electoral, en el caso “Villaver, María Victoria”, ya determinó que estas conductas pueden subsumirse en el artículo 140 del Código Penal (inducir al error al sufragante) y reafirmó que el objetivo es “mantener la pureza del sufragio como base de la forma representativa de gobierno”.

Busca evitar la proliferación de videos falsos que llamen a engaño a los electores LA NACION